En los últimos años, hemos sido testigos de una metamorfosis acelerada. Pasamos de la curiosidad por los chatbots a una realidad donde la Inteligencia Artificial no es una característica opcional, sino una capa fundamental del software moderno. Como ingenieros, nuestra labor ha evolucionado: ya no solo consumimos IA, ahora la integramos, orquestamos y refinamos.

La Evolución: Del Chat a la API

Atrás quedaron los días donde la interacción con LLMs se limitaba a copiar y pegar prompts en una interfaz web. En 2026, la verdadera ventaja competitiva reside en la capacidad de conectar estos modelos con nuestros propios datos y procesos de negocio.

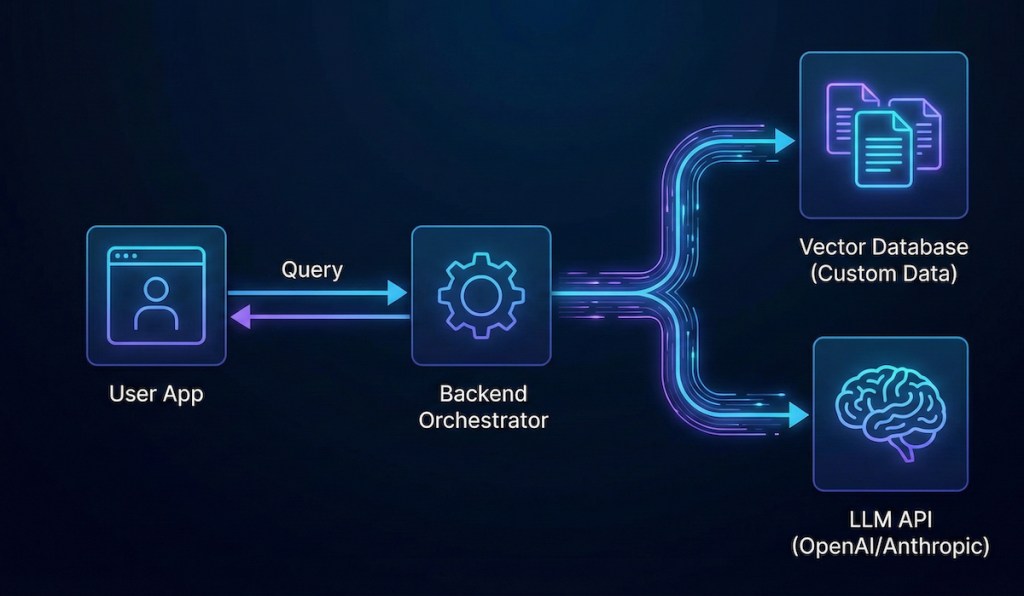

La integración mediante APIs de proveedores como OpenAI o Anthropic permite que el software sea «consciente» del contexto. Esto implica mover la lógica del modelo hacia el backend para garantizar seguridad, observabilidad y escalabilidad.

Integración Técnica: Backend y Frontend

Para quienes venimos de ecosistemas robustos, la integración se ha vuelto sorprendentemente fluida:

- En el Backend (Ruby on Rails): Gracias a gemas como

langchainrbo los SDKs oficiales, podemos encapsular llamadas a modelos dentro de Services o Background Jobs. Es vital manejar los tiempos de respuesta mediante ActiveJob para no bloquear el hilo principal. - En el Frontend (Next.js): El uso del Vercel AI SDK se ha estandarizado. Nos permite manejar flujos de streaming de texto en tiempo real con hooks como

useChat, mejorando drásticamente la experiencia de usuario al reducir la percepción de latencia.

RAG: El Cerebro de la IA con Datos Propios

El concepto más crítico que todo desarrollador debe dominar hoy es RAG (Retrieval-Augmented Generation).

¿Qué es RAG? Es el proceso de proporcionar al LLM información externa y específica antes de generar una respuesta.

A diferencia del fine-tuning (entrenamiento fino), RAG es más económico y permite que la IA tenga «memoria fresca». Almacenamos nuestros documentos en bases de datos vectoriales (como Pinecone o pgvector) y, ante una consulta, recuperamos los fragmentos más relevantes para inyectarlos en el prompt del sistema. Esto elimina las alucinaciones y da autoridad a la respuesta.

Productividad: La Perspectiva del Senior

Con 15 años viendo pasar lenguajes y frameworks, puedo decir que herramientas como Cursor y GitHub Copilot no vienen a reemplazarnos, sino a elevar nuestro nivel de abstracción. Un ingeniero senior ya no pierde tiempo en la sintaxis trivial; se enfoca en la arquitectura, la seguridad y la resolución de problemas complejos. La IA es nuestro mejor «pair programmer», pero el criterio arquitectónico sigue siendo humano.

Conclusión: El Nuevo Rol del Desarrollador

En esta era, el desarrollador ya no es solo un escritor de código; es un Orquestador de Inteligencia. Nuestro valor no reside en saber de memoria una API, sino en saber cómo conectar piezas para crear soluciones que aporten valor real. El futuro pertenece a quienes sepan integrar la potencia de los LLMs con la robustez del desarrollo tradicional.